Controversie politiche, pensiero critico e trappole mentali

In questo e nel prossimo numero della rubrica torneremo su un problema che tormenta tutti coloro che a vario titolo si interessano di comunicare la scienza: il fatto che accrescere le conoscenze scientifiche dei cittadini non sempre permette di ridurre la diffusione della disinformazione, anzi può addirittura avere l’effetto contrario. Cercheremo prima di capire qualcosa in più sulle cause di questo paradosso e poi di ragionare su che cosa si può fare per evitarlo, ammesso che qualcosa si possa fare.

Cominciamo dal fatto che non sempre il nostro ragionamento è guidato dall’obiettivo di essere il più accurati possibile. A volte l’obiettivo, seppure non dichiarato e non consapevole, è quello di confermare le nostre conclusioni preferite, un tema di cui abbiamo già parlato su Query[1]. Nei due casi si può parlare rispettivamente di “ragionamento motivato dall’accuratezza” e “ragionamento motivato direzionale[2]”. Un buon modo per illustrare la differenza tra i due comportamenti è considerare l’acquisto di un’automobile. Quando dobbiamo comprare una macchina nuova e quindi fare un investimento consistente, siamo fortemente motivati a non sprecare i soldi e a valutare la qualità del nostro potenziale acquisto nel modo più obiettivo possibile. Una volta che abbiamo comprato la macchina e non possiamo più tornare indietro, però, le nostre motivazioni cambiano. Se ci rendessimo conto di esserci lasciati ingannare e di avere fatto un cattivo acquisto la nostra autostima ne soffrirebbe, perciò siamo portati a non trattare più in modo oggettivo le informazioni che riceviamo. Se spunta fuori qualche rumorino fastidioso non gli diamo peso, e se vediamo un articolo che elogia una vettura concorrente in quanto ha consumi ed emissioni minori, siamo più portati a liquidarlo come informazione pubblicitaria. Per una scelta che ci coinvolge di meno poiché richiede un investimento molto minore, come il comprare una bicicletta usata, saremo meno motivati ad approfondire i pro e i contro prima dell’acquisto ma anche più disponibili ad accettare le informazioni sfavorevoli dopo l’acquisto.

Ci sono diversi tipi di conclusioni che possono innescare il ragionamento motivato direzionale: per esempio quelle che aumentano la nostra autostima, che ci rendono più ottimisti sul nostro futuro, che concordano con le nostre convinzioni più forti e con la nostra visione del mondo.

Come facciamo a favorire le nostre conclusioni preferite? Possiamo per esempio esaminare le informazioni contrarie con molta attenzione alla ricerca di punti deboli che ci permettano di rifiutarle, mentre accettiamo quelle favorevoli senza controllarle troppo, oppure possiamo passare molto tempo a cercare dati che confermino le nostre idee, mentre non ci sforziamo altrettanto di trovare informazioni contrarie. Inoltre, tendiamo più spesso ad applicare gli stereotipi quando rafforzano le nostre idee, mentre rifuggiamo dagli stereotipi quando le contrastano.

Va sottolineato che tutti questi comportamenti avvengono in modo inconsapevole, dal momento che tendiamo a mantenere l’illusione dell’obiettività. Crediamo di comportarci come dei giudici che soppesano equamente le prove a favore e contro una tesi, ma in realtà ci comportiamo più come degli avvocati di parte, che mettono in buona luce le prove favorevoli e sminuiscono quelle avverse.

Tuttavia, questo tipo di trappola mentale non è invincibile: tornando all’esempio di prima, se la nostra auto si rompe in continuazione, prima o poi rinunceremo a difendere la nostra oculatezza e ammetteremo di aver comprato una macchina scadente.

La ricerca sul ragionamento motivato direzionale si è sviluppata molto negli ultimi due decenni, al confine tra psicologia sociale, economia e scienze politiche, è tuttora in corso e ha varie questioni aperte[3]. Non è compito di un articolo divulgativo toccare gli aspetti ancora in discussione e suscettibili di nuovi sviluppi: ci limitiamo a dire in generale che, sebbene gli effetti del ragionamento motivato direzionale non vadano sopravvalutati, il fenomeno certamente esiste e influenza le nostre capacità di ragionamento.

Non si tratta del resto di una novità: già Tucidide, quasi 2500 anni fa, nella Guerra del Peloponneso osservava un comportamento che si può associare al ragionamento motivato[4], e dopo di lui moltissimi altri studiosi, come tra gli altri Francis Bacon e Charles Darwin, hanno notato il fenomeno e hanno proposto delle contromisure.

Quello che ci interessa qui sono le implicazioni sulla comunicazione della scienza e sull’attività del CICAP.

Facciamo un passo alla volta. Ci rifacciamo agli studi sulla popolazione degli Stati Uniti, che sono più numerosi e coprono una casistica più ampia rispetto a quelli europei. Accettiamo inoltre la premessa che, nonostante la difficoltà di misurare in modo quantitativo la capacità di ragionamento scientifico, alcuni indici che sono stati sviluppati in proposito, come quello di “intelligenza scientifica”, sembrano abbastanza affidabili. K. E. Stanovich definisce l’intelligenza scientifica ordinaria come l’insieme delle capacità di ragionamento critico che permettono di trarre conclusioni valide dalle prove, delle facoltà di percezione cognitiva che permettono di capire quando un problema richiede di applicare tale ragionamento, e della motivazione necessaria per svolgere la faticosa elaborazione delle informazioni richiesta da questi compiti (Stanovich 2011). Un indice che misura tale capacità è stato sviluppato da Dan Kahan (Kahan 2015).

Se interroghiamo il pubblico su varie questioni scientifiche, ci aspettiamo che coloro che hanno un’elevata intelligenza scientifica, così definita, diano mediamente risposte più corrette. Bene, questo è effettivamente vero per la maggior parte degli argomenti; tuttavia, se le domande riguardano questioni ideologicamente controverse come la teoria dell’evoluzione o il cambio climatico, osserviamo un fenomeno molto curioso.

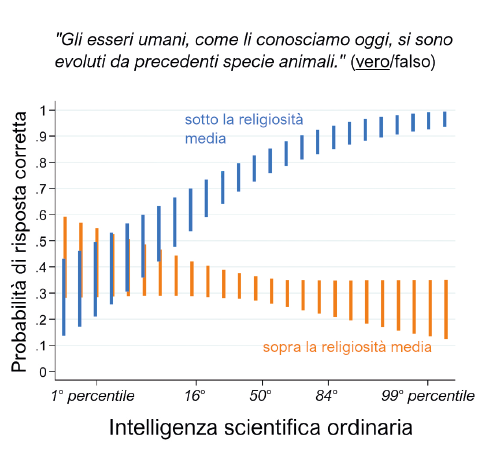

Per quanto riguarda la teoria dell’evoluzione, se dividiamo i rispondenti in base alla religiosità, determinata tramite un questionario, notiamo che soltanto quelli con una religiosità inferiore alla media tendono a dare tante più risposte corrette quanto più è alta la loro capacità di ragionamento scientifico. Per coloro che hanno una religiosità superiore alla media, la percentuale di risposte esatte è grosso modo costante con l’indice di intelligenza scientifica.

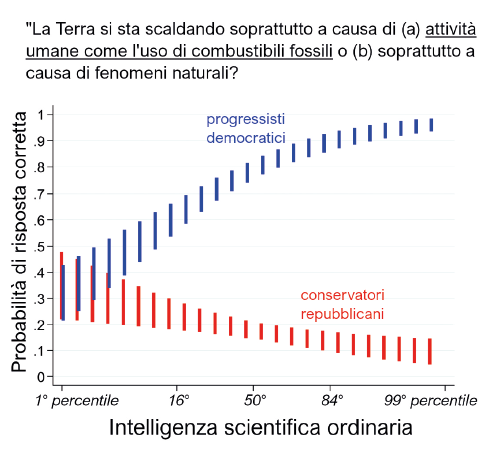

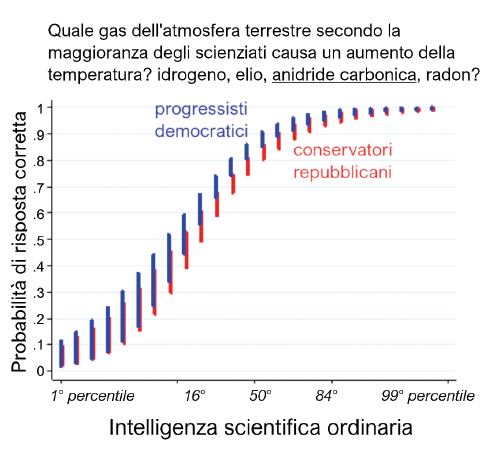

Il fenomeno è ancora più netto con il riscaldamento globale, se dividiamo i rispondenti in base all’appartenenza politica: in questo caso, per i democratici più aumenta l’indice di intelligenza scientifica e più aumenta la percentuale di risposte corrette, mentre per i repubblicani è il contrario: più sono in grado di ragionare scientificamente e più la percentuale di risposte sbagliate aumenta, anziché diminuire. Un risultato sorprendente, che va nella direzione opposta a quella che ci aspetteremmo.

Attenzione, però. Se concludessimo da questi dati che i religiosi e i repubblicani hanno minori conoscenze scientifiche rispettivamente dei non religiosi e dei democratici oppure che hanno minori capacità di ragionamento analitico, faremmo un grave errore, perché questa tesi è chiaramente smentita dai dati. Il problema sta nel modo in cui è posta la domanda.

In primo luogo, il fatto di “credere” nella teoria dell’evoluzione o nel riscaldamento globale non significa affatto averli capiti, come è dimostrato da numerosi studi. Gli studi mostrano che coloro che dicono di “credere” nella teoria dell’evoluzione non ne conoscono affatto i concetti di fondo meglio di coloro che non ci credono (Lawson & Worsnop 2006). Lo stesso vale per il cambiamento climatico.

In secondo luogo, quando chiediamo alle persone se “credono” in una teoria ideologicamente controversa, non gli stiamo chiedendo se hanno capito la teoria scientifica, ma gli stiamo chiedendo implicitamente chi sono e da che parte stanno su un tema fortemente identitario. Queste teorie scientifiche non esistono nel vuoto ma sono profondamente intrecciate con una rete di altre convinzioni che definiscono l’appartenenza a un gruppo: per fare un solo esempio, riconoscere l’elevato rischio posto dal riscaldamento globale all’umanità implica mettere in qualche modo in discussione il modello di sviluppo che ha prodotto questo rischio, ma proprio la difesa di tale modello di sviluppo è un punto fondante dell’identità degli elettori repubblicani. Va anche sottolineato che il rifiuto del consenso scientifico non è affatto un comportamento irrazionale, se visto nel giusto contesto. Le spiegazioni del fenomeno differiscono leggermente, ma in generale possiamo dire questo: per gli individui è più importante mantenere il proprio status all’interno del gruppo sociale cui appartengono rispetto a comprendere correttamente la posizione della scienza su rischi sociali che appaiono spesso astratti o lontani nel tempo. Perciò, nei casi in cui c’è contrasto tra queste due esigenze, gli individui useranno le loro capacità di ragionamento per il primo obiettivo, e quelli con le migliori capacità di ragionamento otterranno i risultati migliori da quel punto di vista (Haidt 2012, Kahan 2015).

Infine, bisogna notare che questo fenomeno non riguarda soltanto le persone religiose e di destra: risultati analoghi sono stati osservati ponendo alle persone di sinistra domande relative al fracking o all’energia nucleare[5]. Anche in questo caso una domanda che apparentemente riguarda solo le conoscenze scientifiche in realtà va a toccare il senso di appartenenza a un gruppo su temi come il rapporto tra ambiente e sviluppo economico, perciò se le persone sono costrette a scegliere tra la propria identità e il consenso scientifico scelgono la prima cosa.

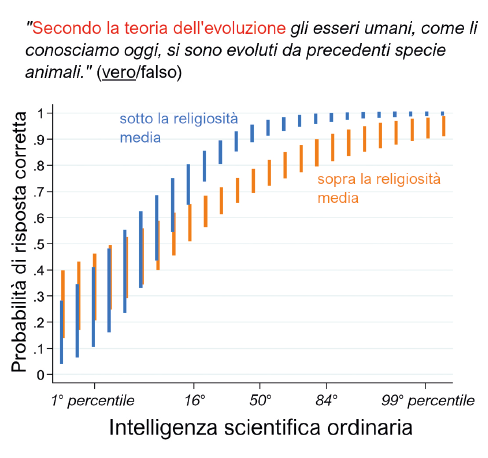

Se però formuliamo la domanda diversamente, in modo da separare la questione delle conoscenze scientifiche dalla propria identità culturale, il quadro cambia completamente. È sufficiente chiedere «Secondo la teoria dell’evoluzione, gli esseri umani si sono sviluppati da precedenti specie animali?» oppure «Secondo la grande maggioranza degli scienziati, quale gas è il maggior responsabile del riscaldamento globale?» per eliminare sostanzialmente la differenza nelle risposte rispettivamente tra religiosi e non religiosi e tra destra e sinistra. Questo dimostra che le persone sono in grado di capire lo stato delle conoscenze scientifiche su evoluzione e riscaldamento globale in maniera proporzionale alla propria intelligenza scientifica, indipendentemente dalle proprie convinzioni politiche e religiose. È importante capire questo punto, tra l’altro perché così eviteremo di spendere un sacco di soldi per una campagna informativa che spieghi alle persone cose che sanno già.

Che cosa possiamo concludere?

In primo luogo, dobbiamo ribadire che il fenomeno controintuitivo che abbiamo appena descritto avviene solo su pochi temi altamente divisivi come quelli già citati, oppure la fratturazione idraulica (in inglese fracking) o la proprietà privata delle armi. Ma su moltissimi altri temi scientifici, che almeno in America non mostrano significative spaccature tra destra e sinistra, le cose vanno come ci aspetteremmo.

Insomma, migliorare le capacità di ragionamento scientifico continua a essere utile per migliorare la comprensione di moltissimi temi legati alla scienza e alla tecnologia, ma non è sufficiente per dirimere le controversie su quei temi che hanno una forte componente identitaria. Questi temi, seppure minoritari in assoluto, sono di grande interesse per il CICAP, perché molti degli argomenti che trattiamo hanno proprio la caratteristica di essere polarizzanti: pensiamo per esempio alle teorie del complotto sull’11 settembre, o alle medicine alternative e all’esaltazione del “naturale” in opposizione alla chimica e a Big Pharma.

In questi casi la tesi che sia la mancanza di conoscenze scientifiche a causare la spaccatura nell’opinione pubblica è smentita dai fatti. Il pubblico non è certamente più informato sui raggi X o sulla pastorizzazione rispetto al riscaldamento globale, eppure su questi temi non c’è nessuna divisione tra destra e sinistra. È la polarizzazione politica a causare la spaccatura sulle questioni scientifiche, non la mancanza di conoscenze scientifiche o di capacità di ragionamento.

Come possiamo affrontare il problema? Cercheremo di capirlo nel prossimo numero della rubrica, a partire dagli studi sperimentali.

Note

1) Si veda per esempio “Il Pregiudizio di Conferma”, di Sara Pluviano e Sergio della Sala, in Query n. 41 - primavera 2020; “Una tassonomia dei “bias” cognitivi: il caso del bias di conferma”, di Roberto Cubelli e Sergio della Sala, in Query n. 44 - inverno 2020.

2) Bolsen, Toby & Palm, Risa. (2019). Motivated Reasoning and Political Decision Making. In Oxford Research Encyclopedia of Politics. Oxford University Press.

3) Kunda, Z. (1990). The case for motivated reasoning. Psychological Bulletin, 108(3), 480–498.

4) «Pareva loro di potere fare ciò senza alcun pericolo, opinando falsamente non esser tanta la potenza ateniese, quanta mostrossi in processo di tempo, perché ne giudicavano più con mal fondato desiderio, che con sicura previdenza, secondo l'usato degli uomini, i quali sperano inconsideratamente ciò che bramano, e ciò che non gradiscono arbitrariamente rigettano.» Della Storia di Tucidide volgarizzata, Libro IV, 108, traduzione di Francesco Predari Boni.

5) Nisbet, E.C., K.E. Cooper, and R.K. Garrett. 2015. The partisan brain: How dissonant science messages lead conservatives and liberals to (dis) trust science. The Annals of the American Academy of Political and Social Science 658(1): 36–66.

Riferimenti bibliografici

- Bolsen, Toby & Palm, Risa. 2019. Motivated Reasoning and Political Decision Making. In Oxford Research Encyclopedia of Politics. Oxford University Press.

- Haidt, J. 2012. The Righteous Mind: Why Good People Are Divided by Politics and Religion. Vintage.

- Kahan, D. 2015. Climate-Science Communication and the Measurement Problem. Advances in Political Psychology, 36, 1-43.

- Lawson, A.E. & Worsnop, W.A. 2006. Learning about evolution and rejecting a belief in special creation: Effects of reflective reasoning skill, prior knowledge, prior belief and religious commitment. Journal of Research in Science Teaching 29, 143-166.

- Stanovich, K.E. 2011. Rationality and the reflective mind. Oxford University Press.