Quando il pioniere della parapsicologia Joseph Rhine coniò l'espressione "effetto declino[1]", non immaginava che nel tempo le sue parole avrebbero assunto un nuovo significato, continuando a dividere gli scienziati a ottant'anni di distanza. Rhine si riferiva al fatto che i soggetti dei suoi esperimenti ottenevano un po' alla volta risultati sempre meno significativi: non riusciva a spiegarsi questo spiacevole fenomeno e pensò che per qualche ragione sconosciuta le loro facoltà extrasensoriali tendessero a "consumarsi" nel tempo.

In realtà si possono immaginare spiegazioni più semplici. Una di queste è la regressione verso la media: quando iniziamo a raccogliere i dati di un campione statistico, qualche valore vicino agli estremi, anche se del tutto casuale, può cambiare notevolmente il risultato medio; via via che il campione si ingrandisce, però, l'effetto di questo exploit influisce sempre di meno e il risultato medio si avvicina a quello previsto dal caso. Ce ne accorgiamo anche nella vita di tutti i giorni quando siamo alle prese con fenomeni casuali: se giochiamo a testa o croce, all’inizio può capitarci di avere fortuna e indovinare sette o otto volte su dieci o di essere sfortunati e sbagliare quasi sempre, ma più andiamo avanti e più il nostro tasso di successo si avvicinerà al cinquanta per cento (a meno che a tirare la monetina sia Silvan).

Un’altra ragione è il famoso "effetto sperimentatore": siamo affezionati alle nostre ipotesi, vorremmo che fossero confermate e, per quanto ci sforziamo di essere obiettivi, tendiamo inconsciamente a interpretare i risultati in modo favorevole alle nostre aspettative, o a ignorare le spiegazioni che le contraddicono. Nei primi esperimenti di Rhine il protocollo non era abbastanza rigoroso per impedire che si manifestassero "falsi positivi" dovuti all’effetto sperimentatore o a una frode da parte del soggetto studiato. Negli esperimenti successivi questi errori furono corretti e i risultati divennero molto più modesti. Non ci sono abbastanza informazioni per capire esattamente che cosa sia accaduto in tutti gli esperimenti di Rhine, ma oggi l’opinione della comunità scientifica è che i suoi soggetti non avessero alcuna facoltà extrasensoriale e che il successo di alcuni studi fosse interamente dovuto a effetti casuali, protocolli sperimentali inadeguati e frodi non scoperte.

L’atteggiamento di Rhine ci può sembrare ingenuo, ma l’effetto sperimentatore è un serio rischio anche per la ricerca scientifica propriamente detta e richiede di progettare l’esperimento con una serie di accorgimenti di cui abbiamo parlato più volte, come il doppio cieco, il campione di controllo, la randomizzazione, eccetera[2]. Allo stesso tempo questi problemi fanno sì che la riproducibilità sia un requisito fondamentale delle teorie scientifiche, come ha ricordato Stefano Bagnasco nello scorso numero di Query. Il singolo risultato positivo non rappresenta necessariamente una nuova scoperta, ma può essere dovuto a una coincidenza, a una fluttuazione statistica o a un errore; potrà entrare nel patrimonio consolidato delle conoscenze scientifiche soltanto quando sarà replicato da altri laboratori. È quello che non succede mai nelle pseudoscienze, dove successi clamorosi come i primi risultati di Rhine o la memoria dell'acqua "scoperta" da Benveniste scompaiono quando gli esperimenti vengono progettati meglio: come diciamo qualche volta con uno slogan, "controllo zero risultato cento, controllo cento risultato zero".

Tutto bene fin qui: la riproducibilità ci fornisce un utile strumento per distinguere tra scienza e pseudoscienza. E allora? Il problema è che la mancanza di riproducibilità può colpire anche le scoperte scientifiche. Spesso vengono presentate nuove scoperte che appaiono statisticamente solide ma che in studi successivi diventano meno robuste: l‘effetto declino si fa sentire anche nella scienza. Un esempio famoso, in psicologia, è il “verbal overshadowing”: la scoperta, avvenuta nel 1990, che la capacità di riconoscere un volto diminuisce dopo averne descritto il ricordo (anziché aumentare come si credeva fino a quel momento).

Questa scoperta ha destato molto clamore (l'articolo originale è stato citato più di 400 volte) ed è stata estesa a tipi di memoria molto differenti. Ma lo stesso scopritore del verbal overshadowing, Jonathan Schooler, ha rivelato molti anni dopo di non essere mai più riuscito negli esperimenti successivi a riprodurre in modo altrettanto robusto l’effetto che aveva ottenuto nello studio del 1990, nonostante gli sforzi fatti[3]. Simili fenomeni di declino dei risultati sono stati osservati sistematicamente, seppure in misura limitata, in biologia e in ecologia[4]. La stessa cosa avviene in medicina, dove c'è una complicazione in più: quando un nuovo farmaco passa dagli studi clinici all’introduzione sul mercato, dove la popolazione dei pazienti è meno omogenea, la sua efficacia diminuisce ulteriormente[5]. Nemmeno la fisica è immune dal problema della mancanza di riproducibilità. Un famoso esempio è la misura del rapporto giromagnetico dell’elettrone, negli anni 1910-1920: in una prima misura il fisico sperimentale Samuel Barnett aveva ottenuto un valore molto simile a quello accettato oggi, ma, dopo aver saputo che Einstein aveva trovato un valore diverso, decise di ripetere la misura, ricavando la seconda volta un risultato molto vicino a quello previsto dal grande scienziato. In realtà il valore misurato da Einstein era sbagliato, ma ci vollero più di dieci anni perché l‘errore fosse riconosciuto[6].

A che cosa è dovuto l’effetto declino negli studi scientifici? Sono state avanzate diverse spiegazioni. Una delle più popolari è il “publication bias”. Immaginiamo che nel mondo cinque gruppi scientifici stiano studiando la correlazione tra un determinato principio attivo e il miglioramento dell’ipertensione. Quelli che non trovano nessuna correlazione in genere tengono il proprio studio nel cassetto, perché difficilmente susciterebbero l’entusiasmo delle riviste scientifiche e dei potenziali finanziatori. Al contrario, quelli che trovano una correlazione tenderanno a scrivere un articolo in merito e probabilmente troveranno una rivista scientifica che lo pubblicherà. Paradossalmente, se quattro gruppi su cinque ottengono risultati negativi e non pubblicano nulla e soltanto uno ottiene risultati positivi e pubblica un articolo, l’unico risultato visibile alla comunità scientifica sarà quello positivo. Quanto più la scoperta sarà clamorosa, tanto più sarà probabile che siano finanziate ulteriori ricerche. A questo punto altri ricercatori salteranno sul carro del vincitore, facendo altri studi che, a causa di un pregiudizio inconscio a favore della scoperta iniziale, tenderanno a corroborarla. Questo, naturalmente, senza prendere in considerazione la possibilità di frodi vere e proprie, che sono un problema a parte. La controprova che la correlazione iniziale nasceva da una coincidenza e non da una relazione causale emergerà solo gradualmente.

Un'altra possibile spiegazione, legata all'effetto sperimentatore di cui abbiamo parlato prima, è la mancanza di rigore nell'analisi dei risultati. Quando l'esperimento non dà risultati significativi, un gruppo di ricerca meno che irreprensibile può analizzare di nuovo i dati fino a trovare una diversa correlazione che è invece significativa. Questo può avvenire attraverso l'inclusione o l'esclusione di determinati elementi del campione o gruppi di controllo, l'analisi post hoc di alcuni sottogruppi, l'investigazione di ipotesi inizialmente non specificate, il cambiamento della definizione di alcuni parametri e la presentazione selettiva dei risultati. Uno studio pubblicato nel 2006 ha dimostrato la pericolosità di queste pratiche, cercando deliberatamente associazioni statisticamente significative ma inverosimili tra segni zodiacali e vari problemi di salute: sul gran numero di correlazioni cercate, alcune emergevano come significative in modo chiaramente casuale, ma isolate dal contesto sarebbero apparse del tutto eccezionali[7].

Per affrontare il problema del publication bias e della flessibilità nell'analisi dei risultati è stato proposto un database condiviso dei dati sperimentali, nel quale gli scienziati registrino le proprie ipotesi e metodologie prima dell’esperimento, e i risultati dopo, indipendentemente dall’esito e dall’eventuale pubblicazione. In questo modo, se di cinque gruppi che si sono registrati solo uno mostrerà di avere dati positivi, sarà chiaro che il principio attivo probabilmente non funziona. Allo stesso modo, sarà più facile verificare se il gruppo di lavoro cerca a posteriori correlazioni diverse da quelle dichiarate prima dello studio.

Un'ulteriore spiegazione dell’effetto declino è la scelta dei criteri statistici con i quali valutare il successo dell’esperimento. Quello di gran lunga più usato è la "significatività statistica", ovvero la probabilità che il risultato dell’esperimento sia dovuto al caso: di solito si richiede una probabilità minore del cinque per cento, valore che si è imposto semplicemente per facilità di calcolo. Come abbiamo già visto su Query[8], però, la significatività statistica non significa molto se non è associata a una buona dimensione dell’effetto osservato. La probabilità che l'effetto del mio farmaco sull'ipertensione non sia casuale può anche essere molto alta, ma in pratica non me ne importa niente se la pressione diastolica passa mediamente da 100 a 98 millimetri di mercurio. Questa considerazione innocua ha uno sgradevole effetto collaterale: si tende a pubblicare prima lo studio che mostra l’effetto più grande, e quindi proprio a contribuire all’effetto declino.

Soprattutto, la significatività statistica non dimostra nulla se non viene confrontata con la probabilità a priori che il fenomeno esaminato esista davvero[9]. Se metto sperimentalmente alla prova un'ipotesi estremamente improbabile, l'ipotesi continuerà a essere molto improbabile anche in caso di risultato positivo con alta significatività. Per esempio, se viene pubblicato uno studio che mostra in modo altamente significativo l’efficacia di un rimedio omeopatico 100 CH o le facoltà extrasensoriali di un sensitivo, novantanove scienziati su cento penseranno che il vero motivo del successo sia una frode o un protocollo sperimentale inadeguato e non un fenomeno autentico. Come abbiamo già visto in questa rubrica, non si tratta di pregiudizio: è del tutto ragionevole pensare che la probabilità a priori di una truffa o di un artefatto statistico sia più alta di quella di un'ipotesi estremamente implausibile e senza riscontri concreti. Ma se, invece di un'ipotesi sui fenomeni paranormali, l’oggetto dell’esperimento è un’ipotesi scientifica a prima vista verosimile, è probabile che l’importanza della probabilità a priori venga trascurata.

Si è occupato a lungo di questo problema l’epidemiologo John P. A. Ioannidis, che ha riassunto le sue conclusioni in un articolo dal provocatorio titolo “Perché la maggior parte delle scoperte pubblicate è falsa[10]”. Nell'articolo Ioannidis analizza i diversi fattori che influenzano la probabilità a posteriori che la correlazione riscontrata da un esperimento biomedico sia vera, dato un risultato statisticamente significativo. Sono più o meno gli stessi fattori che abbiamo citato finora:

Secondo Ioannidis la combinazione di questi fattori fa sì che nella maggior parte degli studi biomedici la probabilità di avere trovato una correlazione autentica sia inferiore al 50%, qualcosa che farebbe mettere le mani nei capelli ai fautori della medicina basata sull’evidenza. Le conclusioni di Ioannidis possono sembrare estreme ma non sono isolate e riflettono la preoccupazione di molti altri metodologi e statistici sul rischio di affidarsi esclusivamente alla significatività come criterio di successo[11]. Per migliorare la situazione Ioannidis propone diverse contromisure, tra le quali proprio la registrazione anticipata degli studi di cui abbiamo parlato prima, una più rigorosa valutazione statistica degli effetti misurati e l'introduzione sistematica di una stima realistica delle probabilità a priori. I lavori di Ioannidis e quelli di altri metodologi mostrano infatti che nella ricerca applicata si tende a sottovalutare le conoscenze di probabilità e statistica necessarie per una corretta analisi dei risultati.

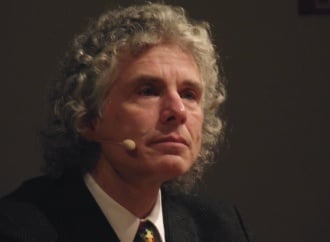

Indipendentemente dalle cause e dai possibili rimedi dell’effetto declino, però, c’è un problema di fondo: se diciamo che la mancanza di riproducibilità è una caratteristica delle pseudoscienze, che cosa dobbiamo concludere quando sono le scoperte scientifiche a non essere riproducibili? La questione è esplosa nel dicembre 2010, quando un articolo di Jonah Lehrer sul New Yorker[12] ha spostato la discussione dall’ambiente accademico al grande pubblico. L'articolo di Lehrer faceva alcuni esempi di effetto declino nella scienza, con un tono un po’ sensazionalistico che ha fatto perdere le staffe a diversi scettici come Steven Novella, PZ Myers e David Gorski. Gli scettici si sono arrabbiati soprattutto perché nelle conclusioni Lehrer sembrava sposare una forma di relativismo postmodernista per cui accettare o meno le conoscenze scientifiche è una semplice questione di scelta personale, anche se in un successivo articolo[13] ha precisato che non erano queste le sue intenzioni.

Come nota però un altro scettico, Matt Nisbet, l’accusa di postmodernismo nasconde probabilmente un po’ di imbarazzo per un argomento sgradevole ma non infondato[14]. Anche i critici più severi di Lehrer, infatti, non negano i problemi di riproducibilità elencati nel suo articolo, ma ne danno un’interpretazione diversa. Secondo Steven Novella[15], per esempio, l’esistenza dell’effetto declino dimostra semplicemente che gli scienziati sono esseri umani e possono commettere errori, a maggior ragione quando il campo di studio è complesso come la medicina o la psicologia, ma questo non impedisce né che scoperte affidabili siano possibili e anzi avvengano di frequente, né che nel lungo termine la comunità scientifica corregga i propri errori.

Questo è vero, ma il punto interessante sollevato dall’effetto declino è un altro: nonostante il peer review e gli altri accorgimenti introdotti nel tempo dalla comunità scientifica, la pubblicazione di conclusioni sbagliate è piuttosto frequente e, quando avviene, la loro falsificazione è spesso un processo lento e laborioso. Di fatto l'attuale prassi scientifica è ancora poco efficace nel distinguere i risultati genuini dal rumore e dagli artefatti statistici. Su quali contromisure adottare ci sono idee diverse, ma il problema esiste ed è oggetto di discussione. Quando ci viene fatta notare la sua esistenza, non dovremmo offenderci, ma accettare la sfida di discutere apertamente come funziona davvero la scienza e quali aspetti hanno bisogno di essere migliorati.

Naturalmente la provvisorietà delle conoscenze scientifiche non deve diventare un pretesto per delegittimare l'impresa scientifica nel suo insieme. Tuttavia la discussione sull’effetto declino serve a mettere in evidenza che la continua autocorrezione caratteristica della ricerca scientifica non riguarda soltanto i risultati, ma anche le metodologie.

In realtà si possono immaginare spiegazioni più semplici. Una di queste è la regressione verso la media: quando iniziamo a raccogliere i dati di un campione statistico, qualche valore vicino agli estremi, anche se del tutto casuale, può cambiare notevolmente il risultato medio; via via che il campione si ingrandisce, però, l'effetto di questo exploit influisce sempre di meno e il risultato medio si avvicina a quello previsto dal caso. Ce ne accorgiamo anche nella vita di tutti i giorni quando siamo alle prese con fenomeni casuali: se giochiamo a testa o croce, all’inizio può capitarci di avere fortuna e indovinare sette o otto volte su dieci o di essere sfortunati e sbagliare quasi sempre, ma più andiamo avanti e più il nostro tasso di successo si avvicinerà al cinquanta per cento (a meno che a tirare la monetina sia Silvan).

Un’altra ragione è il famoso "effetto sperimentatore": siamo affezionati alle nostre ipotesi, vorremmo che fossero confermate e, per quanto ci sforziamo di essere obiettivi, tendiamo inconsciamente a interpretare i risultati in modo favorevole alle nostre aspettative, o a ignorare le spiegazioni che le contraddicono. Nei primi esperimenti di Rhine il protocollo non era abbastanza rigoroso per impedire che si manifestassero "falsi positivi" dovuti all’effetto sperimentatore o a una frode da parte del soggetto studiato. Negli esperimenti successivi questi errori furono corretti e i risultati divennero molto più modesti. Non ci sono abbastanza informazioni per capire esattamente che cosa sia accaduto in tutti gli esperimenti di Rhine, ma oggi l’opinione della comunità scientifica è che i suoi soggetti non avessero alcuna facoltà extrasensoriale e che il successo di alcuni studi fosse interamente dovuto a effetti casuali, protocolli sperimentali inadeguati e frodi non scoperte.

L’atteggiamento di Rhine ci può sembrare ingenuo, ma l’effetto sperimentatore è un serio rischio anche per la ricerca scientifica propriamente detta e richiede di progettare l’esperimento con una serie di accorgimenti di cui abbiamo parlato più volte, come il doppio cieco, il campione di controllo, la randomizzazione, eccetera[2]. Allo stesso tempo questi problemi fanno sì che la riproducibilità sia un requisito fondamentale delle teorie scientifiche, come ha ricordato Stefano Bagnasco nello scorso numero di Query. Il singolo risultato positivo non rappresenta necessariamente una nuova scoperta, ma può essere dovuto a una coincidenza, a una fluttuazione statistica o a un errore; potrà entrare nel patrimonio consolidato delle conoscenze scientifiche soltanto quando sarà replicato da altri laboratori. È quello che non succede mai nelle pseudoscienze, dove successi clamorosi come i primi risultati di Rhine o la memoria dell'acqua "scoperta" da Benveniste scompaiono quando gli esperimenti vengono progettati meglio: come diciamo qualche volta con uno slogan, "controllo zero risultato cento, controllo cento risultato zero".

Tutto bene fin qui: la riproducibilità ci fornisce un utile strumento per distinguere tra scienza e pseudoscienza. E allora? Il problema è che la mancanza di riproducibilità può colpire anche le scoperte scientifiche. Spesso vengono presentate nuove scoperte che appaiono statisticamente solide ma che in studi successivi diventano meno robuste: l‘effetto declino si fa sentire anche nella scienza. Un esempio famoso, in psicologia, è il “verbal overshadowing”: la scoperta, avvenuta nel 1990, che la capacità di riconoscere un volto diminuisce dopo averne descritto il ricordo (anziché aumentare come si credeva fino a quel momento).

Questa scoperta ha destato molto clamore (l'articolo originale è stato citato più di 400 volte) ed è stata estesa a tipi di memoria molto differenti. Ma lo stesso scopritore del verbal overshadowing, Jonathan Schooler, ha rivelato molti anni dopo di non essere mai più riuscito negli esperimenti successivi a riprodurre in modo altrettanto robusto l’effetto che aveva ottenuto nello studio del 1990, nonostante gli sforzi fatti[3]. Simili fenomeni di declino dei risultati sono stati osservati sistematicamente, seppure in misura limitata, in biologia e in ecologia[4]. La stessa cosa avviene in medicina, dove c'è una complicazione in più: quando un nuovo farmaco passa dagli studi clinici all’introduzione sul mercato, dove la popolazione dei pazienti è meno omogenea, la sua efficacia diminuisce ulteriormente[5]. Nemmeno la fisica è immune dal problema della mancanza di riproducibilità. Un famoso esempio è la misura del rapporto giromagnetico dell’elettrone, negli anni 1910-1920: in una prima misura il fisico sperimentale Samuel Barnett aveva ottenuto un valore molto simile a quello accettato oggi, ma, dopo aver saputo che Einstein aveva trovato un valore diverso, decise di ripetere la misura, ricavando la seconda volta un risultato molto vicino a quello previsto dal grande scienziato. In realtà il valore misurato da Einstein era sbagliato, ma ci vollero più di dieci anni perché l‘errore fosse riconosciuto[6].

A che cosa è dovuto l’effetto declino negli studi scientifici? Sono state avanzate diverse spiegazioni. Una delle più popolari è il “publication bias”. Immaginiamo che nel mondo cinque gruppi scientifici stiano studiando la correlazione tra un determinato principio attivo e il miglioramento dell’ipertensione. Quelli che non trovano nessuna correlazione in genere tengono il proprio studio nel cassetto, perché difficilmente susciterebbero l’entusiasmo delle riviste scientifiche e dei potenziali finanziatori. Al contrario, quelli che trovano una correlazione tenderanno a scrivere un articolo in merito e probabilmente troveranno una rivista scientifica che lo pubblicherà. Paradossalmente, se quattro gruppi su cinque ottengono risultati negativi e non pubblicano nulla e soltanto uno ottiene risultati positivi e pubblica un articolo, l’unico risultato visibile alla comunità scientifica sarà quello positivo. Quanto più la scoperta sarà clamorosa, tanto più sarà probabile che siano finanziate ulteriori ricerche. A questo punto altri ricercatori salteranno sul carro del vincitore, facendo altri studi che, a causa di un pregiudizio inconscio a favore della scoperta iniziale, tenderanno a corroborarla. Questo, naturalmente, senza prendere in considerazione la possibilità di frodi vere e proprie, che sono un problema a parte. La controprova che la correlazione iniziale nasceva da una coincidenza e non da una relazione causale emergerà solo gradualmente.

Un'altra possibile spiegazione, legata all'effetto sperimentatore di cui abbiamo parlato prima, è la mancanza di rigore nell'analisi dei risultati. Quando l'esperimento non dà risultati significativi, un gruppo di ricerca meno che irreprensibile può analizzare di nuovo i dati fino a trovare una diversa correlazione che è invece significativa. Questo può avvenire attraverso l'inclusione o l'esclusione di determinati elementi del campione o gruppi di controllo, l'analisi post hoc di alcuni sottogruppi, l'investigazione di ipotesi inizialmente non specificate, il cambiamento della definizione di alcuni parametri e la presentazione selettiva dei risultati. Uno studio pubblicato nel 2006 ha dimostrato la pericolosità di queste pratiche, cercando deliberatamente associazioni statisticamente significative ma inverosimili tra segni zodiacali e vari problemi di salute: sul gran numero di correlazioni cercate, alcune emergevano come significative in modo chiaramente casuale, ma isolate dal contesto sarebbero apparse del tutto eccezionali[7].

Per affrontare il problema del publication bias e della flessibilità nell'analisi dei risultati è stato proposto un database condiviso dei dati sperimentali, nel quale gli scienziati registrino le proprie ipotesi e metodologie prima dell’esperimento, e i risultati dopo, indipendentemente dall’esito e dall’eventuale pubblicazione. In questo modo, se di cinque gruppi che si sono registrati solo uno mostrerà di avere dati positivi, sarà chiaro che il principio attivo probabilmente non funziona. Allo stesso modo, sarà più facile verificare se il gruppo di lavoro cerca a posteriori correlazioni diverse da quelle dichiarate prima dello studio.

Un'ulteriore spiegazione dell’effetto declino è la scelta dei criteri statistici con i quali valutare il successo dell’esperimento. Quello di gran lunga più usato è la "significatività statistica", ovvero la probabilità che il risultato dell’esperimento sia dovuto al caso: di solito si richiede una probabilità minore del cinque per cento, valore che si è imposto semplicemente per facilità di calcolo. Come abbiamo già visto su Query[8], però, la significatività statistica non significa molto se non è associata a una buona dimensione dell’effetto osservato. La probabilità che l'effetto del mio farmaco sull'ipertensione non sia casuale può anche essere molto alta, ma in pratica non me ne importa niente se la pressione diastolica passa mediamente da 100 a 98 millimetri di mercurio. Questa considerazione innocua ha uno sgradevole effetto collaterale: si tende a pubblicare prima lo studio che mostra l’effetto più grande, e quindi proprio a contribuire all’effetto declino.

Soprattutto, la significatività statistica non dimostra nulla se non viene confrontata con la probabilità a priori che il fenomeno esaminato esista davvero[9]. Se metto sperimentalmente alla prova un'ipotesi estremamente improbabile, l'ipotesi continuerà a essere molto improbabile anche in caso di risultato positivo con alta significatività. Per esempio, se viene pubblicato uno studio che mostra in modo altamente significativo l’efficacia di un rimedio omeopatico 100 CH o le facoltà extrasensoriali di un sensitivo, novantanove scienziati su cento penseranno che il vero motivo del successo sia una frode o un protocollo sperimentale inadeguato e non un fenomeno autentico. Come abbiamo già visto in questa rubrica, non si tratta di pregiudizio: è del tutto ragionevole pensare che la probabilità a priori di una truffa o di un artefatto statistico sia più alta di quella di un'ipotesi estremamente implausibile e senza riscontri concreti. Ma se, invece di un'ipotesi sui fenomeni paranormali, l’oggetto dell’esperimento è un’ipotesi scientifica a prima vista verosimile, è probabile che l’importanza della probabilità a priori venga trascurata.

Si è occupato a lungo di questo problema l’epidemiologo John P. A. Ioannidis, che ha riassunto le sue conclusioni in un articolo dal provocatorio titolo “Perché la maggior parte delle scoperte pubblicate è falsa[10]”. Nell'articolo Ioannidis analizza i diversi fattori che influenzano la probabilità a posteriori che la correlazione riscontrata da un esperimento biomedico sia vera, dato un risultato statisticamente significativo. Sono più o meno gli stessi fattori che abbiamo citato finora:

- la dimensione del campione

- la dimensione dell’effetto

- il numero di relazioni testate

- la flessibilità nelle definizioni dei criteri di successo e nei modi di analisi dei risultati

- la competizione tra i diversi gruppi scientifici che studiano quel settore e la necessità di pubblicare il proprio lavoro prima dei concorrenti

- gli interessi economici e i pregiudizi in gioco.

Secondo Ioannidis la combinazione di questi fattori fa sì che nella maggior parte degli studi biomedici la probabilità di avere trovato una correlazione autentica sia inferiore al 50%, qualcosa che farebbe mettere le mani nei capelli ai fautori della medicina basata sull’evidenza. Le conclusioni di Ioannidis possono sembrare estreme ma non sono isolate e riflettono la preoccupazione di molti altri metodologi e statistici sul rischio di affidarsi esclusivamente alla significatività come criterio di successo[11]. Per migliorare la situazione Ioannidis propone diverse contromisure, tra le quali proprio la registrazione anticipata degli studi di cui abbiamo parlato prima, una più rigorosa valutazione statistica degli effetti misurati e l'introduzione sistematica di una stima realistica delle probabilità a priori. I lavori di Ioannidis e quelli di altri metodologi mostrano infatti che nella ricerca applicata si tende a sottovalutare le conoscenze di probabilità e statistica necessarie per una corretta analisi dei risultati.

Indipendentemente dalle cause e dai possibili rimedi dell’effetto declino, però, c’è un problema di fondo: se diciamo che la mancanza di riproducibilità è una caratteristica delle pseudoscienze, che cosa dobbiamo concludere quando sono le scoperte scientifiche a non essere riproducibili? La questione è esplosa nel dicembre 2010, quando un articolo di Jonah Lehrer sul New Yorker[12] ha spostato la discussione dall’ambiente accademico al grande pubblico. L'articolo di Lehrer faceva alcuni esempi di effetto declino nella scienza, con un tono un po’ sensazionalistico che ha fatto perdere le staffe a diversi scettici come Steven Novella, PZ Myers e David Gorski. Gli scettici si sono arrabbiati soprattutto perché nelle conclusioni Lehrer sembrava sposare una forma di relativismo postmodernista per cui accettare o meno le conoscenze scientifiche è una semplice questione di scelta personale, anche se in un successivo articolo[13] ha precisato che non erano queste le sue intenzioni.

Come nota però un altro scettico, Matt Nisbet, l’accusa di postmodernismo nasconde probabilmente un po’ di imbarazzo per un argomento sgradevole ma non infondato[14]. Anche i critici più severi di Lehrer, infatti, non negano i problemi di riproducibilità elencati nel suo articolo, ma ne danno un’interpretazione diversa. Secondo Steven Novella[15], per esempio, l’esistenza dell’effetto declino dimostra semplicemente che gli scienziati sono esseri umani e possono commettere errori, a maggior ragione quando il campo di studio è complesso come la medicina o la psicologia, ma questo non impedisce né che scoperte affidabili siano possibili e anzi avvengano di frequente, né che nel lungo termine la comunità scientifica corregga i propri errori.

Questo è vero, ma il punto interessante sollevato dall’effetto declino è un altro: nonostante il peer review e gli altri accorgimenti introdotti nel tempo dalla comunità scientifica, la pubblicazione di conclusioni sbagliate è piuttosto frequente e, quando avviene, la loro falsificazione è spesso un processo lento e laborioso. Di fatto l'attuale prassi scientifica è ancora poco efficace nel distinguere i risultati genuini dal rumore e dagli artefatti statistici. Su quali contromisure adottare ci sono idee diverse, ma il problema esiste ed è oggetto di discussione. Quando ci viene fatta notare la sua esistenza, non dovremmo offenderci, ma accettare la sfida di discutere apertamente come funziona davvero la scienza e quali aspetti hanno bisogno di essere migliorati.

Naturalmente la provvisorietà delle conoscenze scientifiche non deve diventare un pretesto per delegittimare l'impresa scientifica nel suo insieme. Tuttavia la discussione sull’effetto declino serve a mettere in evidenza che la continua autocorrezione caratteristica della ricerca scientifica non riguarda soltanto i risultati, ma anche le metodologie.

Note

1) J. B. Rhine, Extra-Sensory Perception, Boston: Bruce Humpries, 1934

2) Stefano Bagnasco, "Il potere delle aspettative", in Query 04, Inverno 2010

3) Jonathan Schooler, "Unpublished results hide the decline effect", Nature, 470, 2011, 437, doi:10.1038/470437a, http://www.nature.com/news/2011/110223/full/470437a.html

4) Michael D. Jennions, Anders P. Møller, "Relationships fade with time: a meta-analysis of temporal trends in publication in ecology and evolution", Proc. R. Society B, 269 (1486), 2002, 43–48, http://www.ncbi.nlm.nih.gov/pmc/articles/PMC1690867/

5) John P. A. Ioannidis, "Contradicted and Initially Stronger Effects in Highly Cited Clinical Research", The Journal of the American Medical Association, 294(2), 2005, 218-228, http://jama.ama-assn.org/content/294/2/218.full

6) Enrico Scalas, "L'effetto dei pregiudizi in Fisica", in Scienza & Paranormale 74, luglio-agosto 2007, http://www.cicap.org/new/articolo.php?id=273384

7) Peter C. Austin et al., "Testing multiple statistical hypotheses resulted in spurious associations: a study of astrological signs and health", Journal of Clinical Epidemiology 59, 2006, 964-969, http://www.ncbi.nlm.nih.gov/pubmed/16895820

8) Stefano Bagnasco, "Statisticamente significativo", in Query 01, Primavera 2010

9) Andrea Ferrero, "I rabdomanti, le corse dei cavalli e lo scetticismo", in Query 03, Autunno 2010

10) John P. A. Ioannidis, "Why Most Published Research Findings Are False", PLoS Med. 2(8), 2005, e124, http://www.plosmedicine.org/article/info:doi/10.1371/journal.pmed.0020124

11) J. A. Sterne, G. Davey Smith, "Sifting the evidence – What's wrong with significance tests", BMJ, 322, 2001, 226-231, http://www.bmj.com/content/322/7280/226.1.full

12) Jonah Lehrer, "The Thruth Wears Off", The New Yorker, 13 dicembre 2010, 2010/12/13/101213fa_fact_lehrer

13) Jonah Lehrer, "The Mysterious Decline Effect", Wired, dicembre 2010, http://www.wired.com/wiredscience/2010/12/the-mysterious-decline-effect

14) Matthew C. Nisbet, "When The New Yorker Probes the 'Decline Effect', an Opportunity Emerges to Rethink Science Education", Big Think, 15 dicembre 2010, http://bigthink.com/ideas/25533

15) Steven Novella, "The Decline Effect", Neurologica Blog, 13 dicembre 2010, http://theness.com/neurologicablog/index.php/the-decline-effect/